2024/12/31

Google 不是省油的燈, Veo2 將出OpenAI的Sora要小心了

2024回顧及展望2025與新希望

- 個人職涯:身兼二職,也正式帶領團隊完成重大專案。

- AI應用:長期訂閱及關注AI發展。也建立自己的YouTube 影音頻道,雖然是整合影片生成,圖片生成及音樂生成,也用iMove 簡單製作影片。上傳了短影片及長影片。真的體會到AI 工具的生成威力。

- 自我成長:今年工作績效雖然不錯,長官也給予肯定。但明年在帶領團隊上仍有進步空間。

- 持續學習AI 知識和工具應用在生活及工作上。

- 投資理財:2024年果達標,2025年許多預測都是不確定性高。但是我個人目標仍是10%的報酬率。重心仍在 ETF 0050,至於台積電則是拉回再買。

- 學習泰語:持續在口說上有進步,也在閱讀上有成長。對2025年泰國新聞多接觸,全面性的認識泰國。

- Copilot : 工作上會加強對 copilot 的學習及應用。

- Gemini : Google 畢竟是強大的公司,雖沒有OpenAI 在AI 上有熱度,但其 Veo 2 是讓我對 Sora 失望後的期待。

- 拍照及攝影:這是我的生活樂趣之一。不管是上傳至Instagram 或是Thread /YouTube 都是今年要新嚐試的方向

- 書法:最近在YouTube 上找到許多書法學習及深度鑑賞的影片,會持續下去。偶爾會練練硬筆字

- 造型:找到一付好眼鏡及新的休閒鞋

- 多涉獵不同領域

2024/12/24

Sora 產生影片心得(三)中文提示詞及不同風格嘗試

Prompt :

在細雨霏霏的傍晚,一位撐著透明傘的女子在石板街道上緩步前行,街燈倒映在濕漉漉的地面上。

Prompt:

夜晚的漁村港口,一位老漁夫在小木船上整理漁網,遠處燈塔微微閃爍,海浪輕輕拍打岸邊,夜空繁星點點。

2024/12/22

生成式 AI(Generative AI)應用所衍生的各項發展方向

一、生成式 AI 對算力需求的推動

1. 模型規模持續增長

• 近年來生成式 AI(如 GPT 系列、PaLM、Llama 等)不斷擴張模型參數規模,從過去數億參數成長到數千億、甚至兆級參數。

• 大模型對硬體資源的需求極其龐大,包含 GPU/TPU 等專業加速器、超高頻寬記憶體以及高速網路互連。

• 在研發與推廣過程中,模型不只在訓練時需要大量算力,在推論(Inference)階段,如 ChatGPT 這類應用需要持續提供大量的線上推論服務,也對算力形成大規模且常態性的需求。

2. 資料中心(Data Center)升級與擴建

• 由於生成式 AI 的應用極度依賴雲端資料中心,未來幾年各大超大型雲服務業者(Hyperscalers)如 Amazon、Google、Microsoft、Meta 以及其他專門供應 AI 基礎設施的業者都將持續擴建 GPU/TPU 叢集。

• 相較於傳統 CPU 為主的伺服器,GPU/TPU 伺服器在機架內密度更高,功耗也相對更大;同時還需要冷卻、配電及網路互連的大幅升級。

3. AI 專用晶片與客製化解決方案

• 除了通用 GPU(如 Nvidia、AMD)外,各大企業也積極開發或採用客製化 AI 加速晶片(ASIC、FPGA 甚至 RISC-V 方案),以應對大規模推論的延遲與成本問題。

• 這些客製化解決方案亦仰賴先進製程來降低功耗並提高運算效率。

二、電力需求與能源挑戰

1. 資料中心能耗快速提升

• AI 伺服器高密度部署會造成資料中心整體能耗飆升,未來幾年隨著生成式 AI 普及度提高,對全球資料中心電力需求將持續攀升。

• 目前已有多家機構預測,隨著 AI 工作負載增加,資料中心能耗在短期內(3-5年)將翻倍,部分關鍵數據中心甚至會出現電力供應瓶頸。

2. 冷卻與散熱方案的重要性

• 為應對高功耗晶片及機櫃密度的上升,液冷、浸沒式冷卻等更有效率的散熱技術獲得關注。

• 資料中心選址逐漸考量水資源可近性、電力基礎建設穩定度,以及當地電價與環境法規。未來將出現更多位於高緯度或鄰近再生能源基地的超大規模數據中心。

3. 再生能源與綠色供電壓力

• 全球各地政府與大型科技企業紛紛承諾達成碳中和(Net Zero),對資料中心的能源使用提出更嚴苛的綠電採購與節能要求。

• 由於 AI 推廣需要巨量電力,如何確保綠電供應以支撐算力成長,將是未來幾年重要議題。

三、半導體先進製程的發展

1. 摩爾定律仍在進展,但難度遞增

• 從 7nm、5nm、3nm,再到規劃中的 2nm、1.Xnm,半導體製程每往前推進一代,其研發與製造成本皆大幅上揚,曝光、蝕刻、量測等每個步驟都需要最尖端的設備與技術。

• TSMC(台積電)、三星、英特爾皆在競逐先進製程領先地位,尤其為滿足 HPC(High Performance Computing)與 AI 晶片需求,3nm 及 2nm 製程會被優先分配給高附加價值的客戶(例如蘋果、Nvidia、AMD 及超大型雲服務商的客製晶片等)。

2. Chiplet 與先進封裝技術

• 當單一硅晶圓上繼續微縮變得越來越困難與昂貴,透過 Chiplet(小晶片模組化)與先進封裝技術,將不同功能(CPU、GPU、NPU、IO Die)整合在同一封裝中成為趨勢。

• TSMC CoWoS、Intel EMIB、三星 X-Cube 等先進封裝方案,能在減少整體尺寸的同時,改善延遲與功耗,滿足 AI 需要的大規模運算與高速資料傳輸。

3. 先進製程與運算效率

• AI 晶片對運算效率(TOPS/W, FLOPS/W)非常敏感,先進製程可有效降低功耗並提升時脈、封裝整合度,對大模型訓練與推論極具吸引力。

• 後摩爾時代,除了微縮以外,也將更多著眼於晶體管結構創新(GAA、Forksheet、CFET 等)以及材料突破(如新型絕緣材料、低介電常數介面等),以維持性能增長。

四、綜合展望與趨勢

1. AI 算力需求持續高速成長

• 生成式 AI 將成為企業數位轉型與雲端運算的關鍵驅動力,預計在接下來的 3-5 年,AI 訓練與推論工作負載在整體資料中心比重中顯著提高。

• 結合多領域應用(醫療、製造、語音影像、文本生成等),更會推升 AI 所需的晶片銷量與雲端運算規模。

2. 電力與節能挑戰日益嚴峻

• 數據中心能耗上升帶來的問題,將倒逼各大廠持續研發更高效率的硬體(先進製程 + 先進封裝 + 硬體加速器)與更有效率的冷卻技術,同時也增加對綠電的需求。

• 政府面臨電力基礎建設規劃與碳排放政策的挑戰,企業亦需在高效能運算與環保節能之間取得平衡。

3. 半導體先進製程高度集中化

• 由於先進製程門檻超高,未來頂尖的先進製程將持續集中在少數廠商手上(台積電、三星、英特爾),且市場需求多半來自 HPC、AI、手機旗艦 SoC。

• 半導體供應鏈仍存在地緣政治風險,主要先進製程廠積極在多地布局(美國、歐洲、日本等)以降低風險,也會推升整體製造成本。

4. 軟硬體協同設計與新架構興起

• 生成式 AI 驅動下,硬體廠商與雲服務業者將更緊密合作,共同優化軟硬體體系架構(例如 AI 專用指令集、分散式訓練架構、混合精度運算等)。

• 量子運算、光子運算、記憶體計算(In-Memory Computing)等新型態技術,也在測試階段嘗試解決傳統架構瓶頸。這些技術能否在 5-10 年內商業化,仍需關注技術成熟度與成本效益。

結論

•生成式 AI 的爆發 帶動大模型訓練與推論需求,使 AI 算力需求在未來數年持續快速增長,進而推升資料中心的電力需求與冷卻難度。

•半導體先進製程 在硬體性能與能耗比的提升上扮演關鍵角色;然而,隨製程演進,投資成本、技術門檻與地緣政治風險同步升高,將使先進製程高度集中化與全球供應鏈緊張並存。

•面對龐大的用電量與環保節能挑戰,各大科技廠、雲服務商與政府必須在 高效能運算、綠電供應 與 技術創新 之間取得平衡。預料未來幾年,圍繞著 AI 晶片研發、先進封裝技術以及資料中心能源效率提升的投資與技術突破仍將持續加速。

AI 產業無疑是未來全球經濟與科技發展的核心驅動力之一,從硬體晶片到軟體服務、再到各垂直應用,皆蘊藏著豐富的成長機會。但投資人應同時認知到該產業的快速變革與競爭風險,並配合全球經濟、產業週期、公司財報表現進行綜合判斷。最終,能否在 AI 股市題材中獲得長期且穩健的報酬,關鍵在於對公司基本面、技術與估值的深度分析,以及合宜的投資組合與風險控管。

2024/12/18

Sora 產生影片心得(二)

Three elegant and vibrant koi fish, each with unique patterns of red, white, and gold, gracefully swimming in a serene pond. The water is crystal clear, reflecting the sunlight and casting soft ripples as the koi move. Lily pads float gently on the surface, surrounded by blooming lotus flowers. The scene is tranquil, with a hint of soft shadows from overhanging trees and subtle bubbles rising to the surface.

2024/12/14

Sora 產生影片心得(一)

A cheerful and cute girl, around 7 years old, wearing a light blue summer dress, is happily playing with a fluffy golden retriever puppy in a colorful garden filled with blooming flowers. The puppy playfully jumps and chases after a small red ball the girl is throwing. The sunlight creates a warm, golden glow, with birds chirping in the background and butterflies fluttering around.

重新產生的影片如下:

2024/12/08

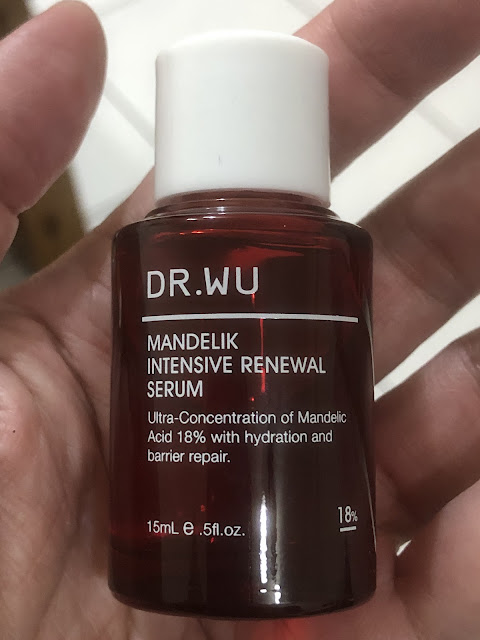

DR.WU 18%杏仁酸居家煥膚入門組使用心得

不含皂鹼的潔顏凝膠,內含杏仁酸與水楊酸,可淨化並溫和去角質。

容量:50mL (1.7 fl. oz.)

使用方法:取適量塗抹於微濕臉部,輕柔按摩30秒。以溫水徹底沖洗乾淨並輕拍乾。可於早晚每日使用。

第二項:Mandelik Intensive Anti-Acne Serum(杏仁酸密集抗痘精華)

添加杏仁酸、水楊酸與硫磺配方,有助改善痘痘肌膚。

容量:5 mL (0.17 fl. oz)

Step S 特別護理

Renewal System(更新系統)

針對粗糙及易長痘之肌膚

適用膚質:中性至混合性肌膚

使用方法:取適量塗抹於需改善之部位。早晚皆可使用。

第三件:Mandelik Intensive Renewal Serum (杏仁酸高濃度煥膚精華)

採用 18% 高濃度杏仁酸,有助於保濕並修護肌膚屏障。

容量:15mL (0.5 fl. oz.)

說明:此產品為高濃度杏仁酸煥膚精華液,提供溫和的去角質效果,同時添加保濕及修護配方,能改善膚質粗糙、調理毛孔及增強肌膚防護力,讓膚質更細緻光滑。

使用方法:在清潔後、上化妝水(toner)前,取適量塗抹於全臉。

一週使用2-3次,建議於夜間使用。

使用第三天心得:皮膚暗沉有改善,乾燥脫皮現象也不明顯了。

使用一週心心得:鼻頭毛孔開始變小了。

2025 春節後以下這份 5ml 已完成。另外再到屈臣士加購 20ml

成年人的愛情糾葛-愛情小說般的現實人生:瓊瑤與張忠謀婚姻故事背後的多面真相

2024/12/07

蛋黃酥界愛馬仕-陳耀訓蛋黃酥

ChatGPT o1 能力展示

下面是一個例子,透過一個複雜的問題並給出詳盡的推導過程,展示我在深度分析與知識運用上的新能力。

問題示例:假設有一個幾何問題如下——

在一個圓內,給定三個點 A、B、C,這三點都在圓周上,並且形成一個三角形 ABC。已知角 ACB = 30°,且圓的半徑 R = 10。假設 AB 是該三角形中最長的一邊,求邊 AB 的長度。

分析過程:

1. 已知條件:

• A、B、C 三點在同一圓上,即 ABC 為一個內接三角形。

• 圓半徑 R = 10。

• 角 ACB = 30°。

• 假設 AB 是最長邊。由於在內接三角形中,對著最大邊的角度最大,因此 ABC 中最大邊為 AB 意味著與 AB 相對的角 C 是最大的角。但我們已知角 C = 30°,30°相對而言很小,這表示另外兩個角 A、B 一定比 30° 更小。這點值得再斟酌,因為若 C 為 30°,則 A、B 這兩個角應該較大,否則很難出現 AB 是最長邊的情況。讓我們往下探討。

在一個內接三角形中,如果 C 是最小角,則對應的邊 AB 應該是最短的邊。但題中設定 AB 是最長邊,這透露出一個關鍵:C 並非最小角。那為什麼給了角 C = 30°,卻說 AB 是最長邊呢?必須注意的是,在圓上,最大的角必對應最大的弧。或許這不是一個常規配置。我們試著用圓周定理從另一個角度出發。

2. 圓周角定理:

在圓上,內接角 C = 30° 對應的弧 AB 所 subtend 的中心角必為 2 × 30° = 60°。

也就是說,在該圓中,連接 A、B 的弧對應的圓心角為 60°。

3. 連結圓心 O 與考慮幾何性質:

設 O 為圓心。

因為 A、B、C 在圓周上,OC = OA = OB = R = 10。

由角 C = 30° 的資訊可推得:

• 弧 AB 所對的中心角為 60°。

若我們僅考慮弧 AB 對應的中心角 AOB = 60°,則在以 O 為圓心半徑為 10 的圓中,AOB 是一個等腰三角形(OA = OB = 10),∠AOB = 60°,故三角形 AOB 實際上是一個等邊三角形,這意味著 AB = OA = OB = 10。

但這個結果只考慮了中心角和弧度的對應,不包含 C 點的條件(C 在圓上且 ∠ACB=30°)。讓我們再更細緻地將 C 放入考慮。

4. 關於點 C 的定位:

我們知道 ∠ACB = 30°,這是由點 C 在圓周上對弧 A…B 的內接角度。

內接角等於對應中心角的一半。這裡對應的中心角為 AOB = 60°,而內接角 ACB = 30° 正好是 60° 的一半,這說明 C 是位於那條弧 AB 的某個位置,使得從 C 看 AB 時的內接角為 30°。但這個條件其實已經與上面的推斷一致:如果弧 AB 對應中心角 60°,那任何在該弧上的點(不包括 A 與 B)看向 AB 的角度都會是 30°(只要 C 不與 A、B 重合)。這說明 C 的存在並沒有改變 AB 的長度計算,反而是對 AB 長度的確證。

換句話說,只要角 ACB = 30° 對應的是那段弧 AB,AB 就對應了 60° 的中心角,故 AB = 2 × R × sin(∠AOB/2) = 2 × 10 × sin(60°/2) = 20 × sin(30°) = 20 × 0.5 = 10。

不過,這是一個基本內接角和弧長關係的公式。更直接的方法是:

在以 O 為中心的圓中,∠AOB = 60° 且 OA = OB = 10,則 AOB 為等邊三角形,直接知 AB = 10。

5. 驗證 AB 是否為最長邊:

若 ∠ACB = 30°,則其餘兩角的分配狀況如何?若 C 是最小角,則對面邊 AB 應該是最短邊;但我們的條件卻說 AB 是最大邊。這點必須要重審題意:

• 若題目明確敘述「AB 是該三角形中最長的一邊」,那可能意味著 A、B、C 點的排列有所特別之處。實際上,若 ABC 是內接於半徑為 10 的圓,AB = 10 並不算短(因為邊長最大可達到直徑 20),此時 ∠C 為 30°,則其他兩角 A、B 必然更小於 30°,這在一般內接三角形設定中比較罕見。

讓我們嘗試另一種解釋:

• 已知 ∠ACB = 30°,表示 ACB 是一個很小的角。而對應弧 A…B 是固定的 60°。如果 AB 是最長邊,則這個三角形可能不是「尖角三角形」;也許 AB 對應的是最大弧(180°以上)的對側,但是那會使 C 位於另一側弧上,看 AB 的角度不會是 30°。

事實上,對於一個內接三角形來說,如果其中一個角只有 30°,剩餘兩個角的和必為 150°,他們很容易各自分配到大於 30° 的值(例如 75° 與 75°)。如果 C = 30° 是最小角,那 AB 對應最大角就不該是 C,而應是另外一個角。可題中假定 AB 是最大邊,則相對的角 C 應為最大角,矛盾出現了。

此時,我們必須認清:

• 角 C = 30° 是由弧 AB 所決定的。

• 如果 C 為 30° 並且是最大角,則 A 和 B 都必小於 30°,這不可能。

因此有可能題目本身存在邏輯矛盾,或者是題目中「AB 是最長邊」屬於額外的條件用來檢驗推論者的思考。如果忽略此矛盾,只憑幾何條件(∠ACB=30°、R=10)來求 AB 長度,我們得到的最合乎幾何規律的解答是 AB = 10。

結論:

在一個半徑為 10 的圓中,若有一個內接三角形 ABC,且 ∠ACB = 30°,根據圓周角與中心角的關係,對應的弧 AB 所 subtend 的中心角為 60°,因此 AB = 10。即使題目中關於「AB 是最長邊」的描述可能不符一般內接三角形的角邏輯,我們的幾何推導依然可以嚴謹地求出邊 AB 的長度。

透過上述例子,我展示了以下新能力:

• 深度分析:不僅是給出答案,而是在過程中多次檢查條件間的邏輯一致性和合理性。

• 知識運用:熟悉圓周角定理、內接三角形性質、等邊三角形幾何特性、三角函數關係等多領域知識。

• 批判審查:當題目中的條件產生矛盾時,能夠理清問題並指出潛在的矛盾點,而不只是盲目給出結論。

這就是我新能力展示的一個例子。

以上是 ChatGPT o1 自己用數學問題來展示其能力,接下來第二個問題是我自己對購買 MacBook Pro 來做AI 應用的問題。

開題:我想了解 MacBook Pro AI 算力到達什麼水平,請提供專業的分析及方法,方便我選擇要購買的型號

ChatGPT o1 回答:

下面將從專業的角度,綜合當前市場訊息與技術指標,對 MacBook Pro 在 AI 算力與應用上的表現進行分析,並提供評估方法。希望能協助您在選購機型時更有依據。

1. 背景與演進趨勢

蘋果在近年來逐步以自研晶片(如 M1、M2、M3 系列)取代英特爾處理器。其中,除了 CPU 核心與 GPU 核心外,Apple Silicon 中的「Neural Engine」(神經引擎)是專門為機器學習(Machine Learning, ML)與人工智慧(AI)推論任務而設計的硬體加速器。下列是各世代 Apple Silicon 所提供的基本 AI 運算資源趨勢:

• M1 系列:配備 16 核心 Neural Engine,每秒可執行數千億次運算(TOPS 級別為 11 TOPS,官方宣稱可達 11 trillion operations per second)。

• M2 系列:Neural Engine 效能提升,理論上每秒可超過 15 TOPS。

• M3 系列:(截至目前公布資訊)預期在 Neural Engine 效率、功耗以及與 GPU/CPU 協同運作上再提升,以支援更高效的 ML 推論工作。

除了 Neural Engine,M 系列晶片的 GPU 核心在部分機器學習工作負載(如 TensorFlow Metal Plugin 或 Apple Core ML 框架的訓練和推論)中也能提供一定的加速,特別是對圖像類推論、影像識別、即時影像處理等任務。

2. 「AI 算力」的定義與指標

在評估 MacBook Pro 的 AI 算力時,須先釐清您要執行的任務類型及對性能的要求:

• AI 推論(Inference):將已經訓練好的模型用於實際應用中,如影像分類、自然語言處理的文字生成等。

• AI 訓練(Training):從頭開始或進行模型微調(Fine-tuning),特別是大型模型如深度神經網路的訓練往往需要大量運算資源與較長運算時間。

在實際情境中,MacBook Pro 更偏向「推論」和「小規模或中小型模型訓練」的優化。與高階 NVIDIA GPU(如 RTX 4090、A100、H100)相比,M 系列晶片並非設計用來大規模訓練巨量參數模型。在 MacBook Pro 上跑大量訓練任務仍不如專業工作站或雲端 GPU 來得高效。

因此判斷AI算力時可以考量以下指標:

1. Neural Engine 的 TOPS 數據:代表設備在 ML 推論上的理論頂峰效能。

2. GPU 加速能力:看 GPU 核心數量及與 Apple Metal ML 框架的效能測試,特別在影像推論與小型模型訓練。

3. 整合的 ML 框架與優化:如 Apple 提供的 Core ML、Metal Performance Shaders (MPS)、TensorFlow for Mac with MPS 加速等,都能影響實際 AI 工作的處理性能。

3. 選購策略與建議

(1) 主要應用為推論與輕度模型調整

如果您的應用集中在已訓練好模型的部署(如執行 Stable Diffusion 圖像生成、語音轉文字、自然語言處理的文字補全、影像分類)或是小模型的微調,則較新的 M2 Pro/Max 或 M3 Pro/Max MacBook Pro 都能獲得不錯的體驗。

• M3 系列預期優勢:改良的 Neural Engine、更高效能的 GPU 核心,有助於提升推論速度與即時處理能力。

• M2 Pro/Max 依然有競爭力:如果您不強求最新技術,M2 Max 具備更多 GPU 核心及高頻寬記憶體(Unified Memory),能有效加速某些 ML 負載。

(2) 有適度的模型訓練需求(中等規模)

若您希望在本機進行中等規模的訓練(如對中小型模型做 Fine-tuning),選擇 GPU 核心數較多、記憶體(Unified Memory)較大版本的 MacBook Pro,有助於提升訓練速度與容納較大型的模型參數。

• M2 Max / M3 Max 版本通常提供更多 GPU 核心(最高可達 38 核甚至更多)與更高記憶體上限(32GB、64GB、甚至 96GB),對於需在本機訓練模型的工程師會較有幫助。

• 使用官方的 TensorFlow for Mac (with MPS) 或 Pytorch with MPS 加速等方式,以及 Apple 提供的 ML 框架 Core ML Tools,可以提高訓練速度。

(3) 大規模深度學習訓練

如果您的工作重心是訓練大型深度學習模型(如大型語言模型、多億級參數的 Transformer),那麼即使是頂配的 MacBook Pro 仍顯不足。這種情況更建議使用雲端 GPU(如 Google Cloud、AWS、NVIDIA DGX Station)或專業工作站級顯示卡。MacBook Pro 比較適合用於本地快速原型開發、測試與小規模模型調整,但並非大規模訓練的主力。

4. 實務測試方法

在選擇機型時,可考慮以下測試方法來客觀評估:

• Benchmark 工具與範例:

• 使用 TensorFlow with MPS 或 PyTorch with MPS 在本機跑標準化的 ML Benchmarks(如 ResNet-50 圖像分類的推論與訓練速度測試)。

• 對某些已知的 Transformer 模型執行簡單的推論性能測試(例如對 GPT-2 小型模型的生成速度)。

• 比較不同配置:

在 Apple Store 或第三方評測網站上尋找對同一代晶片不同規格下 (如 Pro vs Max, 不同 Unified Memory 配置) 的 ML 性能測試數據。

• 檢查記憶體容量:

AI 模型的參數量與訓練數據集大小將受到記憶體限制。在 MacBook Pro 上,統一記憶體(Unified Memory)的容量對於能否一次載入整個模型非常關鍵。測試在不同 RAM 配置下能否一次執行完整的 batch 以及是否發生 memory swap,觀察訓練/推論速度與穩定度的變化。

5. 結論與建議

• 如果您主要用於 AI 推論、行動研究、Demo 展示或中小規模訓練:選擇 M2 Pro/Max 或 M3 Pro/Max 的 MacBook Pro 均能提供不錯的 ML 效能,M3 將可能有更好的能效與更優的 Neural Engine。建議挑選具較高記憶體的版本(如 32GB 或以上),以及較多的 GPU 核心配置。

• 如果您對 AI Training 有較高規模要求:MacBook Pro 仍可作為開發機器,但無法取代大型 GPU 伺服器或工作站。您可在 MacBook Pro 上開發原型並透過雲端資源進行大規模訓練。

綜上,MacBook Pro 所提供的 AI 算力已足以應付許多日常機器學習工作與推論需求,在 Apple 生態系(Core ML、Metal)中更有良好的整合度。然而,若您需要大規模深度學習訓練的算力,仍須考慮搭配雲端或專業 GPU 工作站。透過上述分析、測試方法與考量面向,您可更有信心地選擇適合自己需求的 MacBook Pro 型號與配置。

回答的很好,所以 單就推論應用記憶體版本最好是高於 32GB,至於訓練則還是用GPU 伺服器或工作站。但是2024/12/07 這個時間點,它沒有列出 M4 系列,可見訓練資料尚未納入,回答時也未搭配 Search 功能。

以上兩個問題,可以感受到 o1 模型的回應速度有明顯提升。